[解決済み] バックプロパゲーション・ニューラルネットワークで非線形活性化関数を使用しなければならない理由は何ですか?[クローズド]

2022-04-22 07:19:37

質問

ニューラルネットワークについていろいろ読んでいて、単層のニューラルネットワークの一般的な原理は理解できました。追加層の必要性は理解できますが、なぜ非線形活性化関数が使われるのでしょうか?

この質問の後に、この質問が続きます。 バックプロパゲーションで使われる活性化関数の微分とは何ですか?

どのように解くのですか?

活性化関数の目的は、以下の通りです。 ネットワークに非直線性を持たせる

そして、これは説明変数と非線形に変化する応答変数(ターゲット変数、クラスラベル、またはスコア)をモデル化することを可能にします。

ノンリニア は、入力の線形結合から出力が再現できないことを意味します(これは、直線にレンダリングされる出力とは異なります--これを表す言葉は アフィン ).

がない場合は、別の考え方で ノンリニア なぜなら、これらの層を合計すると、別の一次関数が得られるからです(上記の定義を参照)。

>>> in_vec = NP.random.rand(10)

>>> in_vec

array([ 0.94, 0.61, 0.65, 0. , 0.77, 0.99, 0.35, 0.81, 0.46, 0.59])

>>> # common activation function, hyperbolic tangent

>>> out_vec = NP.tanh(in_vec)

>>> out_vec

array([ 0.74, 0.54, 0.57, 0. , 0.65, 0.76, 0.34, 0.67, 0.43, 0.53])

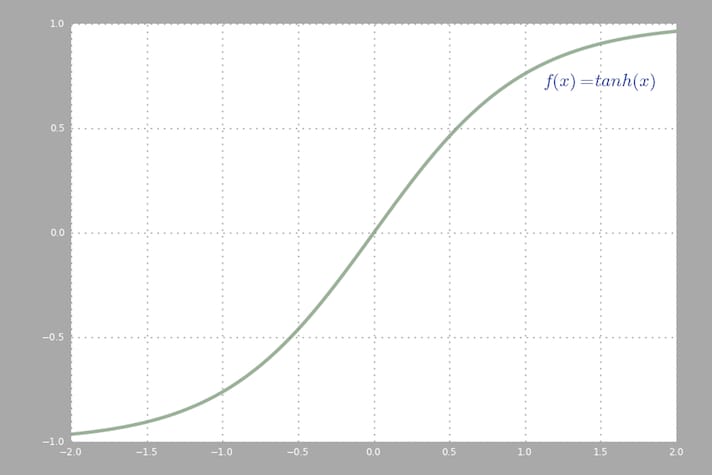

backpropでよく使われる活性化関数( ハイパーボリックタンジェント ) を-2から2まで評価したものです。

関連

-

[解決済み】直線x=2, y=3, 3x+2y=6で形成される三角形の点での直心を求める方法とは?[クローズド]。

-

[解決済み】n個のノードを持つ有向グラフの最大エッジ数は何個ですか?[クローズド]。

-

[解決済み] LaTeX: 数学モードで3行をスタックする

-

[解決済み] Latexで関数の下に文字を配置するには?

-

[解決済み】ポリゴンの点のリストが時計回りに並んでいるかどうかを判断する方法は?

-

[解決済み】なぜ10進数は2進数で正確に表現できないのですか?

-

[解決済み】最小値と最大値がわかっている数値の範囲を縮小する方法

-

[解決済み】線分の法線ベクトルを計算するには?[クローズド]。

-

[解決済み] バックプロパゲーション・ニューラルネットワークで非線形活性化関数を使用しなければならない理由は何ですか?[クローズド]

-

[解決済み] GUIDは常に一意であると仮定しても安全ですか?

最新

-

nginxです。[emerg] 0.0.0.0:80 への bind() に失敗しました (98: アドレスは既に使用中です)

-

htmlページでギリシャ文字を使うには

-

ピュアhtml+cssでの要素読み込み効果

-

純粋なhtml + cssで五輪を実現するサンプルコード

-

ナビゲーションバー・ドロップダウンメニューのHTML+CSSサンプルコード

-

タイピング効果を実現するピュアhtml+css

-

htmlの選択ボックスのプレースホルダー作成に関する質問

-

html css3 伸縮しない 画像表示効果

-

トップナビゲーションバーメニュー作成用HTML+CSS

-

html+css 実装 サイバーパンク風ボタン

おすすめ

-

[解決済み】Mathematica の行列の対角化

-

[解決済み】直線x=2, y=3, 3x+2y=6で形成される三角形の点での直心を求める方法とは?[クローズド]。

-

[解決済み】n個のノードを持つ有向グラフの最大エッジ数は何個ですか?[クローズド]。

-

[解決済み] 大きな符号なし2進数から小さな2進数の引き算

-

[解決済み] スケールファクターまで

-

[解決済み] 矩形を回転させる最も簡単な方法

-

[解決済み] 2つのGPS座標間の距離を計算する

-

[解決済み】線分の法線ベクトルを計算するには?[クローズド]。

-

[解決済み] 標準的な正規化ではなく、なぜソフトマックスを使用するのですか?

-

[解決済み] バックプロパゲーション・ニューラルネットワークで非線形活性化関数を使用しなければならない理由は何ですか?[クローズド]