Python3 はエンコーディングの問題を解決します: UnicodeEncodeError: 'gbk' codec can't encode character '\xa9' in position

2022-02-19 18:21:46

元のブログ記事へのリンクです。 http://www.aobosir.com/blog/2016/12/08/python3-UnicodeEncodeError-gbk-codec-can't-encode-character-xa9/。

開発環境

- Pythonサードパーティライブラリ: lxml, Twisted, pywin32, scrapy

- Pythonバージョン: python-3.5.0-amd64

- PyCharmソフトウェアバージョン: pycharm-professional-2016.1.4

- コンピュータのシステム Windows 10 64ビット

開発環境をまだ構築していない方は このブログの記事 .

Scrapyを使ってクローラープロジェクトを書く際、ある中国のウェブサイトをクロールして、DOSターミナルでクロールしたページのソースコードを印刷すると、様々なエンコーディングエラーが発生します。

クロールされたターゲットURL http://blog.csdn.net/github_35160620/article/details/53353672

エラーで表示されるコード。

def next(self, response):

body_data = response.body.decode('utf-8', 'ignore')

print(body_data)

pass

実行:対応するクローラープロジェクトのパスに来て実行する。

scrapy crawl crawler name

表示されるデバッグメッセージに、コーディングエラーがあることがわかります。

print(body_data)

UnicodeEncodeError: 'gbk' codec can't encode character '\xa9' in position 6732: illegal multibyte sequence

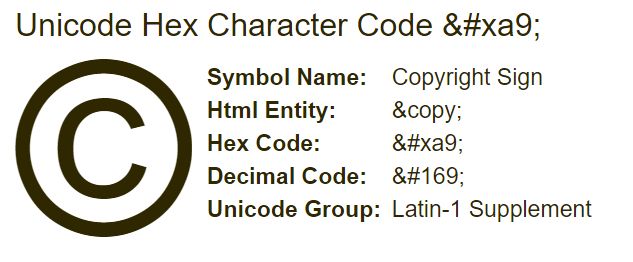

見てみると、この

u'xa9'

ユニコード・エンコーディングで表現される文字は

©

.

このエラーの解決策として考えられるのは

上記のコードを修正します。

def next(self, response):

body_data = response.body.decode('utf-8', 'ignore').replace(u'\xa9', u'')

print(body_data)

pass

次にプログラムを実行します。

scrapy crawl crawler name --nolog

となり、上記のコーディングエラーはなくなりました。クロールされたページのソースコードが正常に出力されています。

ご訪問ください。 http://www.aobosir.com/

関連

-

ユニコード・オブジェクトは、ハッシュ・エラーの解決前にエンコードする必要があります。

-

ERROR: 要件ファイルを開くことができませんでした。[Errno 2] そのようなファイルまたはディレクトリがありません: 'requirements.txt'.

-

Error: cannot run program--createprocess error=2,The system cannot find specified file.

-

python3 failed to start Fatal Python error: initfsencoding: unable to load file system codec

-

ImportError: 名前 '_validate_lengths' をインポートできない。

-

AttributeError: 'module' オブジェクトには 'SSL_ST_INIT' 属性がない ソリューション

-

scipyという名前のモジュールがない場合の解決策|エラー

-

Pythonでナンバープレート自動認識システムを作ろう!楽しくて実用的です。

-

Logistics Regressionにおけるcoef_とintercept_の具体的な意味についてsklearnで解説します。

-

pyinstaller パッケージ生成 .exe 実行ファイルエラー "IndexError: tuple index out of range"

最新

-

nginxです。[emerg] 0.0.0.0:80 への bind() に失敗しました (98: アドレスは既に使用中です)

-

htmlページでギリシャ文字を使うには

-

ピュアhtml+cssでの要素読み込み効果

-

純粋なhtml + cssで五輪を実現するサンプルコード

-

ナビゲーションバー・ドロップダウンメニューのHTML+CSSサンプルコード

-

タイピング効果を実現するピュアhtml+css

-

htmlの選択ボックスのプレースホルダー作成に関する質問

-

html css3 伸縮しない 画像表示効果

-

トップナビゲーションバーメニュー作成用HTML+CSS

-

html+css 実装 サイバーパンク風ボタン

おすすめ

-

解決済みお客様のCPUは、このTensorFlowバイナリが使用するようにコンパイルされていない命令をサポートしています。AVX AVX2

-

Solve 'DataFrame' オブジェクトに 'sort' 属性がない。

-

Pandasの属性エラーです。AttributeError: 'Series' オブジェクトに 'reshape' 属性がない Solution

-

PythonがNameError: name '_name_' is not definedのようなエラーを発生させる。

-

Pythonモジュールの簡単な説明(とても詳しいです!)。

-

Python Djangoプロジェクトログクエリシステム

-

Pythonソケットプログラミング [WinError 10061] ターゲットコンピュータがアクティブに拒否しているため、接続できない。

-

tkinter モジュールを使った Python 倉庫番ゲーム

-

Mac環境でのbrewコマンドが見つからないエラーの解決方法

-

AttributeError:partially initialized module ''has no attribute'' (most likely dueto a circular import)